Вы по адресу, если ищете бесплатную альтернативу VMware vSphere, Microsoft Hyper-V и Citrix XenServer. В этой статье я расскажу о Proxmox VE — бесплатной платформе для виртуализации, — а потом разберу, как выбрать сервер под Proxmox VE. Так что заваривайте что-нибудь вкусное, и мы начнём.

Важные моменты и инструкции для работы с Proxmox

Возможности и преимущества Proxmox

Системные требования Proxmox VE

Сервер для Proxmox VE (советы по подбору)

Proxmox Virtual Environment, он же Proxmox VE, он же Проксмокс (разг. „Прокс“) — это опенсорс-платформа на базе программных решений QEMU (Quick Emulator), KVM (Kernel-based Virtual Machine) и LXC (Linux Containers), которая позволяет разделять физические ресурсы сервера и создавать виртуальные машины, контейнеры и кластеры, а также виртуализировать хранилища, сети и управлять ими через WEB-интерфейс и CLI (Command line interface).

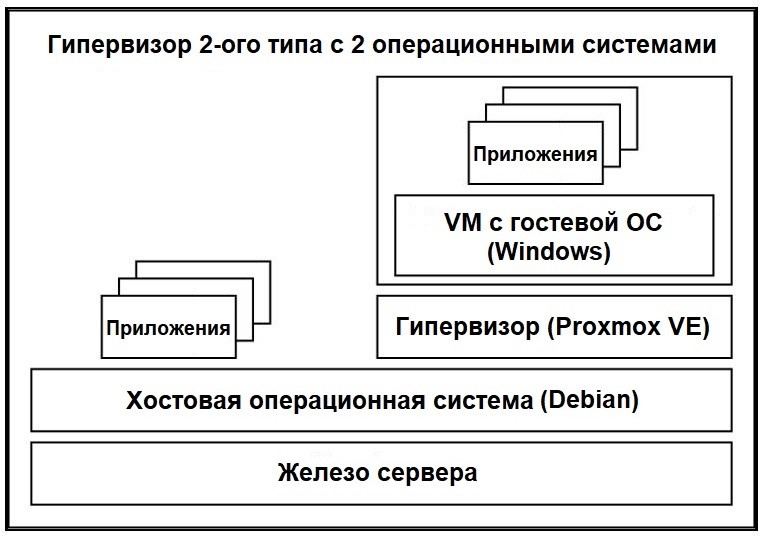

Если проще, то Proxmox — это гипервизор 2-ого типа. То есть между железом сервера и Проксмоксом есть прослойка в виде хостовой операционной системы Debian, основанной на модульном ядре Linux.

Гипервизор — это меццалуна или нож, который разрезает пиццу (сервер) на несколько кусочков (виртуальные машины). Подробнее о сходствах пиццы и виртуализации можно почитать в другой моей статье „Как выбрать сервер для виртуализации“ :)

Интересный факт! Да, Proxmox работает на ОС Debian, что относит его ко 2-ому типу, но некоторые считают, что Proxmox относится к 1-ому типу из-за использования KVM. Некоторые вообще считают его оболочкой для гипервизоров KVM и LXC. Поэтому не удивляйтесь, если встретите другую точку зрения — тема дискуссионная.

Первая версия Proxmox VE вышла в релиз в 2008 году, и с того момента платформа непрерывно развивается, обновляется и популяризируется. На 2022 год по всему миру работает более 600 000 хостов Проксмокс; а самое главное — он бесплатен (распространяется по лицензии GPLv2). Продаются только некоторые репозитории и дополнительная поддержка.

Если вы разбираетесь в виртуализации или работали с платформой PVE, то смело переходите к следующему заголовку статьи.

Но если вы 1 lvl только погружаетесь в виртуализацию и/или хотите освежить память по PVE, то ниже будут шпаргалка со всем необходимым. Учите английский, друзья :)

Используйте эту часть статьи как шпаргалку (добавить в закладки Ctrl + D):

QEMU/KVM Virtual Machines и Linux Container — два типа технологий виртуализации, поддерживаемых Proxmox VE (будем считать контейнеры — виртуализацией);

Host System Administration — про задачи, выполняемые на хосте Proxmox VE, такие как Package Repositories, Network Configuration, System Software Updates, External Metric Server, Disk Health Monitoring, Logical Volume Manager (LVM), ZFS на Linux;

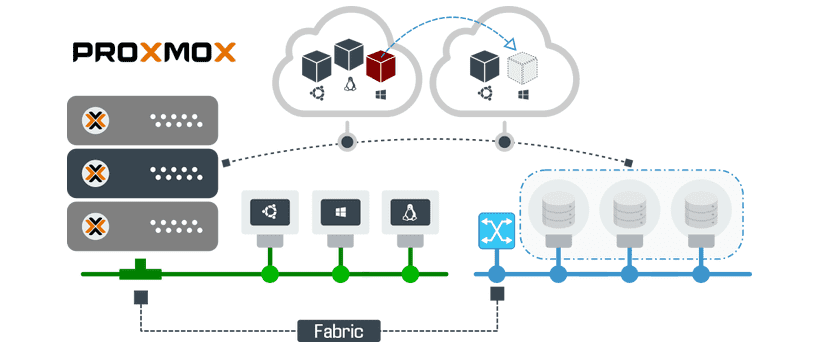

Cluster Manager — объединение хостов Proxmox VE в кластеры;

После создания кластера вы сможете настроить High Availability для своих виртуальных машин и контейнеров;

Storage — обзор всех поддерживаемых технологий хранения данных в Proxmox VE: Ceph RBD, ZFS, User Mode iSCSI, iSCSI, ZFS over iSCSI, LVM, LVM thin, GlusterFS, NFS и Proxmox Backup Server;

Настройка гиперконвергентной инфраструктуры с развертыванием Ceph Cluster;

Backup and Restore — как использовать встроенный менеджер резервного копирования;

Firewall — подробное описание работы встроенного брандмауэра Proxmox VE Firewall;

User Management — про работу аутентификации и разрешений в Proxmox VE;

Developer Documentation — руководство, как получить доступ к исходному коду и как отправлять исправления, чтобы ваши доработки были включены в следующий релиз Proxmox VE.

Во-первых, Proxmox — не идеален (кто-то сомневался?).

Во-вторых, PVE — это бесплатный софт с открытыми исходниками (лайк от малого бизнеса с ограниченным бюджетом).

У полной свободы есть преимущества (о них расскажу ниже) и недостатки: PVE можно поставить почти на любой “калькулятор”, что приведёт к плохой работе. А если полазить по настройкам, станет ещё хуже :) Поэтому, выходя за рамки базовых задач, не ждите в проксмоксе user-friendly на уровне надкушенного яблока.

Например. Во времена Windows 2008, при её использовании в качестве гостевой системы, приходилось подбирать параметры виртуализуемого железа (контроллер дисков, сетевую карту) и версии драйверов. И технология Ballooning (общая оперативная память на виртуалки) работала не очень стабильно.

Некоторые вещи (например, создать кластер) сделать „чуть“ сложнее, чем в VMware или Citrix. Предупреждён — значит не лезь она тебя сожрёт вооружен.

Да, многое придётся делать своими силами, так что смело переходите по ссылке на Proxmox Support Forum и добавляйте страницу в закладки. Ctrl+D, друзья, Ctrl+D :)

Итак, преимущества Proxmox:

Открытый исходный код, Debian и полная свобода действий. Хотите установить на хост другие приложения или дополнительные инструменты мониторинга? Без проблем. Вы можете настроить маршрутизацию, VPN и NAT прямо на гипервизоре — без необходимости отдельной виртуальной машины-роутера;

Бесплатное ПО, платить нужно только за поддержку, если нет возможности администрировать самому (характерно для энтерпрайз бизнеса). Но платным “подписчикам” доступны отдельные репозитории, вроде как с более стабильными версиями пакетов. Но это не точно;

Встроенная служба резервного копирования с возможностью автоматизации бэкапирования;

Быстрое развертывание гостевых систем по типовым шаблонам;

Библиотека установочных образов;

Proxmox поддерживает множество операционных систем в качестве гостевых, поскольку использует KVM. Как популярные, вроде GNU\Linux и Windows, так и менее популярные — вроде FreeBSD. Можно запустить и MacOS, правда чтобы соблюсти чистоту лицензии, Proxmox придётся ставить на Mac;

Proxmox VE может использовать как локальные, так и сетевые хранилища для размещения виртуальных машин. Есть нативная поддержка Ceph из GUI, но без высококвалифицированного специалиста лучше не тратьте на это время;

Простое администрирование через WEB-интерфейс, для ценителей есть API и консольные команды;

Кластерный режим Proxmox позволяет управлять несколькими серверами с одной страницы и проводить живую миграцию виртуальных машин;

Real-Time Monitoring (RTM) — мониторинг нагрузки в реальном времени;

Не нужно совместимое серверное железо. PVE запустится там, где запустится Linux;

Низкие системные требования Proxmox, и минимальный процент потери общей производительности на виртуализацию;

Полная свобода действий, никаких ограничений вендора, как это происходит, например, с VMware vSphere, где чётко прописан список совместимого железа (поэтому у VMWare всё хорошо работает, но только на железе из HCL);

Proxmox поддерживает полную и "легкую виртуализацию" (или изоляцию) с технологией OpenVZ. Это работает только с Linux, но потери производительности CPU/RAM близки к нулю;

Многое другое.

У Proxmox VE нет строгого HCL (Hardware Compatibility List) или списка совместимых аппаратных средств — если запустится Linux/Debian, значит запустится и PVE, но всё же перечислю рекомендации с сайта Proxmox:

|

Минимальные оборудование для Proxmox VE (только для тестов) |

|

|

CPU — 64bit (Intel EMT64 или AMD64), поддержка технологий виртуализации Intel VT, AMD-V, CPU/Mainboard (для использования KVM Full Virtualization) RAM — от 1 ГБ Жёсткий диск Одна сетевая карта Proxmox VE можно установить как гостевую систему на ПК, если есть поддержка вложенной виртуализации. Отлично для тестов и ознакомления с системой. |

|

|

Рекомендуемое оборудование для Proxmox VE (для рабочих систем) |

|

|

CPU — мультипроцессорный 64bit (Intel EMT64 or AMD64), поддержка Intel VT/AMD-V CPU/Mainboard (для использования KVM Full Virtualization) RAM — минимум 2 ГБ для ОС и служб Proxmox VE. Для Ceph или ZFS требуется дополнительная память, примерно 1 ГБ памяти на каждый ТБ используемого хранилища. Также для Ceph нужен первоклассный специалист, а для ZFS — память с коррекцией ошибок (ECC) Дисковая подсистема. Нужны две, для гипервизора и для виртуальных машин (это может быть единый аппаратный массив):

Сетевая карта — от 1 Гбит/c или больше. Поддерживаются избыточные гигабитные сетевые карты и дополнительные сетевые карты (в зависимости от предпочитаемой технологии хранения и настройки кластер) — 10 Гбит/c и выше. Proxmox VE лучше устанавливать поверх 64-битной Debian. Чаще ставят готовым установщиком, но у этого варианта есть минус: нельзя поставить на софтрейд сразу, а на Debian можно. |

|

Да, проксмокс нетребователен, поэтому иногда им пренебрегают в расчётах производительности целевой системы. НО!

Эти системные требования Proxmox VE не учитывают:

количество виртуальных машин;

нагрузки гостевых систем.

А от этих двух параметров будет зависеть 95-99% конфигурации, если мы говорим о чистой системе с Proxmox.

Например, у вас небольшой типовой офис: контроллер домена, 1С — две виртуалки и что-то ещё по мелочи. Тут всё просто, выбирайте базовые модели предыдущих поколений — Dell T430 или HP ML350p Gen8. Лучше взять сразу два одинаковых сервера — для отказоустойчивости.

Совершенно другая ситуация, если у вас огромный офис, много сотрудников и задач:

Терминальный сервер на 100 человек;

1С ERP;

СУБД;

WEB-сервер на несколько сайтов;

Почтовый сервер для разных подразделений;

Несколько файловых серверов;

Рендер-ферма — для 3D моделирования в CAD. Здесь упомяну, что если вы работали c VMware и, например, Nvidia Grid, то знаете про разделение графического процесса по виртуальным машинам (vGPU), когда каждой ВМ выделяют фиксированный объем видеопамяти. В Proxmox VE это не поддерживается, но можно целиком пробросить графический ускоритель в виртуальную машину (привет, passthrough);

Autodesk Revit и Revit Server — для информационного моделирования зданий (BIM);

И другие.

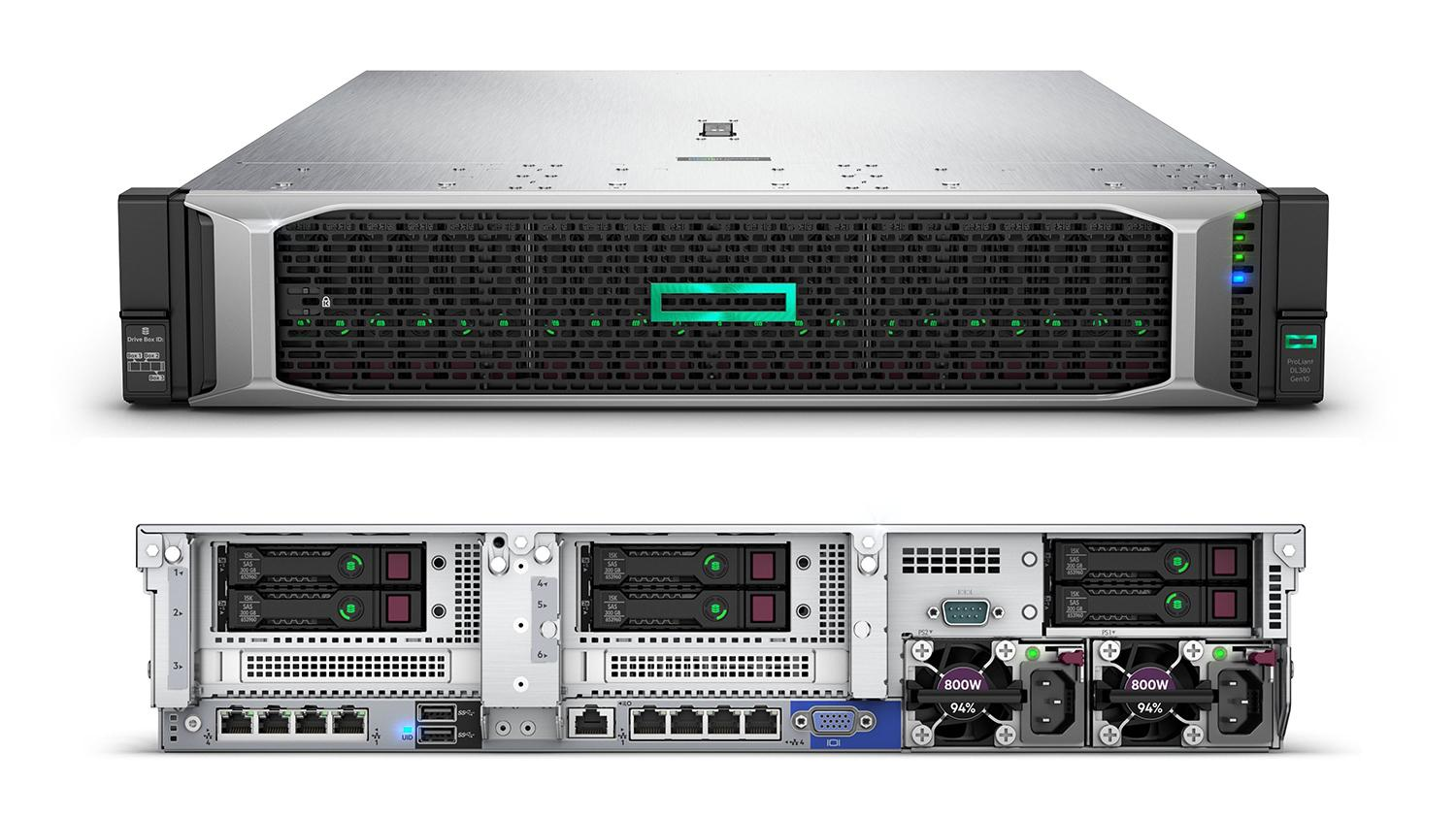

Одного сервера точно не хватит. Тут нужен герой кластер мощных серверов с сотнями ГБ оперативной памяти, объемными и быстрыми накопителями, системы хранения, коммутаторы, сети, графические ускорители и т.д. Если говорить о серверах, то смотрите на: Dell R740 или HPE DL385 Gen10 Plus v2.

Чем больше виртуальных машин и сложнее характер нагрузки, тем производительнее нужна система. Чтобы точно рассчитать будущие характеристики, нужно тестировать виртуальные машины (ВМ) под нагрузкой. Для этого берите бесплатные тест-драйвы у хостинг-провайдеров или арендуйте ВМ на месяц. Результаты по всем виртуалкам суммируйте, добавляйте 5% на Proxmox VE и 20-30% про запас на всю систему — это негласный стандарт.

Да, я говорю о процентах, а не о конкретных цифрах, потому что не знаю ваших задач, но общие рекомендации по комплектующим дам.

Если нет желания или возможности разбираться в подборе конфигурации сервера, то обращайтесь к нашим менеджерам на servermall.ru. Получите бесплатную профессиональную консультацию и КП за час.

Ну а теперь перейдем к железякам :)

Влияние комплектующих часто переоценивают или недооценивают. Верное решение (как это обычно бывает) где-то посередине. Например, сервер может по всем параметрам подходить под задачу, кроме сетевой карты, но она и станет бутылочным горлышком, тормозящим всю систему.

Совет №1: Уделите комплектующим не меньше внимания, чем софту. Последний можно поменять, оптимизировать, а с железом могут быть сложности. От аппаратной части зависит ваша гибкость, доступность, эффективность, производительность и коэффициент консолидации (количество ВМ на 1 физический сервер). И окупаемость тоже не должна исчисляться сотнями лет, если так не задумано изначально :)

Поэтому динозавры старое оборудование (HP ProLiant G6, Dell PowerEdge Gen 10 или ПК времён CS 1.6), которое использовалось под другие задачи, вряд ли подойдёт под Proxmox VE и нормальную работу виртуальных машин.

Не получится работать с высоким аптаймом большому количеству людей;

Даже если заведётся, не выйдет заменить отдельные комплектующие на более мощные и современные (вертикальный рост);

Устаревший процессор и малый объем памяти не лучшие друзья виртуализации и Proxmox;

В старом сервере или ПК мало ОЗУ? Значит будет мало ВМ. Простая арифметика.

Совет №2: Проработайте задачу, проведите тесты — займёт неделю или месяц. Возможно, старый сервер и подойдёт, но лучше выяснить это заранее, чем во время простоя бизнеса.

Совет №3: Покупайте сервер с заделом на будущее. Одно из важнейший преимуществ сервера над ПК — это масштабирование, которое зачастую прямо пропорционально высоте сервера (в монтажных единицах, 1U = 44.45 см = 1.75‘).

Двух или четырёхсокетный сервер может кратно нарастить производительность в будущем, а объемные дисковые полки или корзины позволят расширить хранилище — быстро и относительно недорого. В эту же компанию входят слоты расширения.

Если сэкономите в моменте и возьмёте бюджетный сервер, то в будущем придётся покупать ещё один, либо полностью менять на новый.

Совет №4: Оптимальный сервер для виртуализации в небольших компаниях — это среднебюджетная модель в форм-факторе 2U и больше (5U, если форм-фактор Tower). Новейшие 1U серверы с компактными SSD — отличный выбор, если есть деньги.

Но вы можете смело выбирать из двух-трёх последних поколений: восстановленные серверы Servermall стоят сильно меньше новых, не уступают в надёжности и поставляются с полноценной гарантией 5 лет на всё.

Общие советы по серверу обсудили, теперь пробежимся по комплектующим: CPU, RAM, дисковая подсистема и сетевой адаптер.

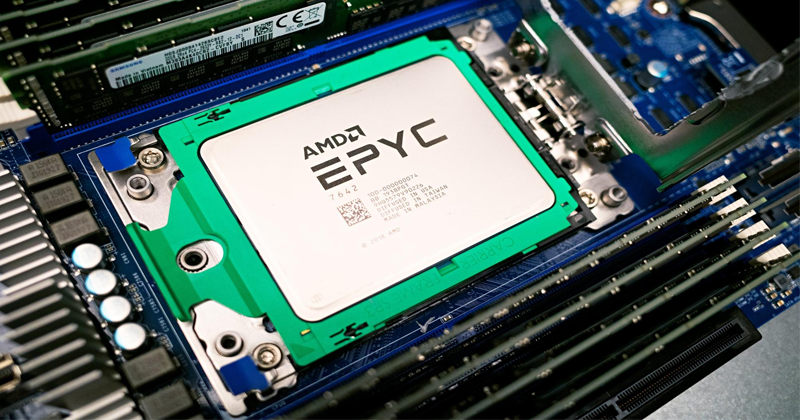

Установленный в сокет серверный процессор AMD EPYC 7642

В нашем блоге на Хабре выходила большая познавательная статья про серверные (и не только) GPU и процессоры. В ней я подробно рассказал о линейках от Intel и AMD. Два гиганта, которые поделили почти весь рынок пополам. И вам придётся выбрать что-то одно. Сделать кластер из серверов на процессорах разных вендоров — вряд ли получится.

Начнём с Intel — это компания-пионер, которая долгое время безоговорочно доминировала на рынке CPU, поэтому их преимущества: большой выбор из предыдущих поколений и отличная оптимизация софта. Но ситуация немного переломилась с выходом архитектуры Zen от AMD.

Сейчас цены и производительность близки у обеих компаний; технологии в процессорах одинаковые или во многом альтернативные. Разницу нужно выискивать тестами под лупой. Иногда впереди Intel Scalable из-за лучшей оптимизации, а иногда AMD EPYC из-за своих performance/watt характеристик. В некоторых сценариях разница в пару процентов, а в некоторых — десятки.

Ремарка. Процессоры Intel Scalable могут выдавать больше ГГц на ядро, чем AMD EPYC, но это будет намного дороже.

AMD добилась отличного соотношения цены к производительности в последних поколениях EPYC 7003 и рекордной доли в сегменте x86-процессоров ~ 27,7%. В серверном сегменте цифра меньше ~ 11.6%, но рост есть. Да, корпоративные клиенты и сисадмины часто консервативны, но это не значит, что процессоры AMD EPYC хуже.

Кстати, у процессоров AMD EPYC есть одно важное преимущество. Некоторое ПО лицензируют посокетно (например, вы решите сменить Proxmox на Citrix в будущем) — это значит, что можно сэкономить на количестве лицензий.

Например:

|

Четрые двухсокетных сервера |

Шесть двухсокетных сервера |

|

8 x EPYC 7742 с 64 ядрами = 512 ядер ($6950 каждый, $55 600 все). 8 x Citrix Hypervisor — Advanced Edition — Perpetual Per Socket ($8 000* все). |

12 x Intel Xeon Platinum 8380 с 40 ядрами = 480 ядер ($8666 каждый, $103992 все). 12 x Citrix Hypervisor — Advanced Edition — Perpetual Per Socket ($12 000 все). |

|

Итого: $63 600. *Цена приблизительна. Может быть больше или меньше. |

Итого: $116 000. Если не учитывать стоимость процессоров, то разница все равно в треть стоимости. |

Насчёт совместимости — процессор для Проксмокса должен поддерживать одну из двух проприетарных технологий виртуализации. Они есть во всех современных серверных ЦПУ соответствующих вендоров, так что вряд ли вы наткнётесь на несовместимое железо:

AMD-V (Virtualization Technology), Vi;

Intel VT (Virtualization Technology), VT-x, VT-d и VT-c.

|

Конкретные советы, как выбрать CPU для Proxmox |

|

Совет №1 — выбирайте тот же бренд процессора, на котором уже работает ваша IT-инфраструктура. Монобрендовые системы зачастую работают эффективнее из-за хорошей совместимости. Если строите инфраструктуру для виртуализации с нуля, то опирайтесь на конкретные задач, которые нужно решить, а не на вендора. |

|

Совет №2 — по характеристикам CPU. Если вы ограничены в пространстве под IT-инфраструктуру, то берите процессоры с большим количеством ядер и высокой тактовой частотой. Но учитывайте, что они дороже и выделяют больше тепла. Если вам нужна производительность ВМ, то делайте акцент на тактовой частоте. А количество ядер и потоков прямо пропорционально влияют на количество возможных виртуальных машин. |

|

Совет №3 — по распределению vCPU (виртуальный процессор с одним ядром). Консервативное правило админов — 1 vCPU на 1 ВМ. Не предоставляйте виртуальным машинам много vCPU сразу — это снизит коэффициент консолидации. Сначала устройте тест-драйв, который покажет: сколько нужно ядер приложению; какой характер и интенсивность нагрузки на виртуальные процессоры. Те же SQL-серверы требуют больше ядер, чем почтовые, файловые или радиус серверы. |

|

Совет №4 — по тестированию ВМ. Тесты можно провести быстро (1-7 дней) или долго (1-4 месяца). Они выявят закономерности и помогут избежать высокой конкуренции за ядро, память, сеть и т.д. И наоборот — если процессор(ы) слабо нагружены, и можно увеличивать коэффициент консолидацию (больше ВМ на хосте). |

Три планки регистровой памяти в сервере

Серверы для виртуализации (для Proxmox VE в частности) — одни из самых требовательных к оперативной памяти. Часть пирога отъедает система (гипервизор). Большая часть памяти нужна виртуальным машинам и установленным на них приложениям. И ещё сверху про запас нужно 20-30%, а лучше больше.

|

Советы по выбору RAM для Proxmox VE |

|

Совет №1 — ответьте на 6 простых вопросов, которые помогут в подборе.

|

|

Совет №2 — по распределению vRAM. Даже если у вас избыток ОЗУ, не выделяйте под ВМ больше памяти, чем требует задача. Протестируйте, сколько на практике нужно пользователю и (или) приложениям для нормальной работы. Офисному сотруднику для Windows 10 и MS Office достаточно 4-5 ГБ ОЗУ. Если без разбора выделить 16 ГБ, лучше не станет, а хуже в масштабах сервера — может. |

|

Совет №3 — по объему RAM. Сделайте всё, чтобы памяти хватало на все задачи. Виртуальные машины, которым не хватает ОЗУ, намного чаще обращаются к накопителю. Чем больше избыточных запросов к диску, тем меньше производительность приложений, Debian и Proxmox VE. И здесь мы вспоминаем запас в 30%, который выручит в случае перерасхода памяти. |

|

Совет №4 —по коррекции ошибок. Вам нужна ECC-память (англ. error-correcting code memory). Она автоматически исправляет спонтанные ошибки битов памяти. Даже не думайте брать non-ECC память! |

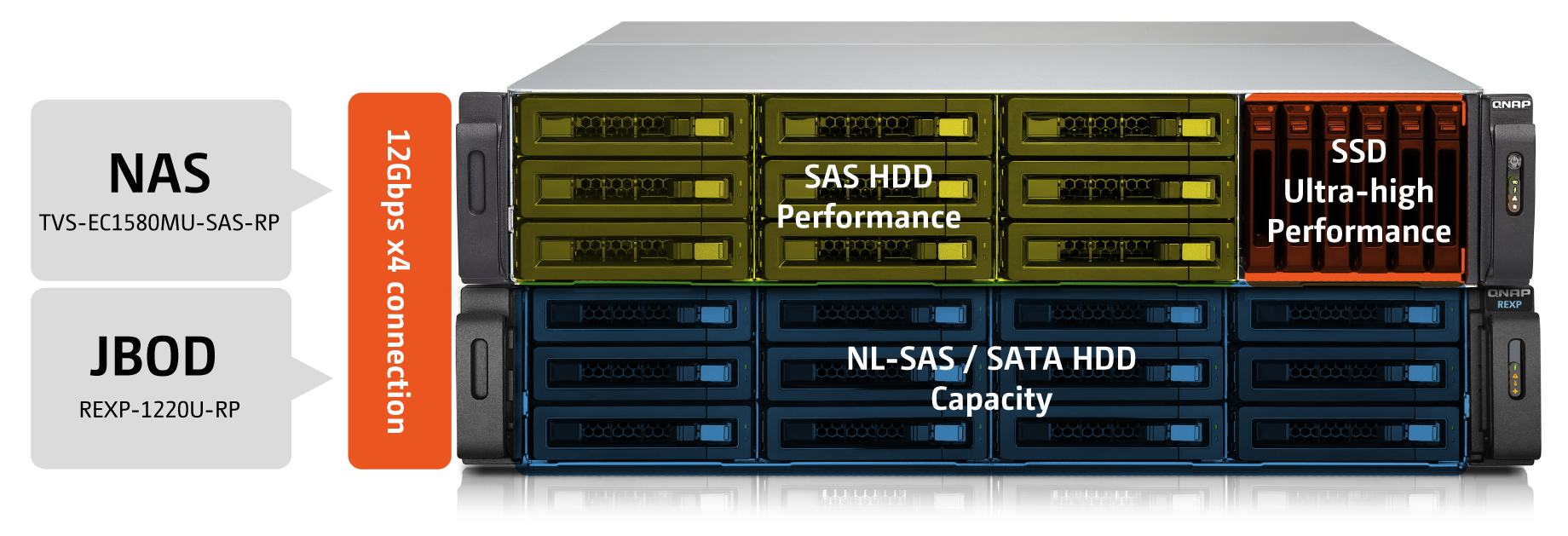

Самый производительный и одновременной дорогой вариант для Proxmox VE (как, впрочем, для всех остальных систем виртуализации… да и вообще для любых систем) — это SSD-накопители. Минимальные задержки, высочайшие показатели чтения/записи и максимальная производительность в сложных задачах, таких как высоконагруженные базы данных.

Менее производительный, но более бюджетный вариант — это SAS HDD. Если сделать RAID 0, 6, 10, 50 или 60, то вырастает скорость работы и общий аптайм сервера. Ну а каждый ГБ памяти в HDD традиционно выходит дешевле, чем у SSD.

|

Советы по накопителям для Proxmox VE |

|

Совет №1. SATA HDD нужно аккуратно использовать для Proxmox VE. Их производительности может не хватить для Proxmox VE с большим количеством ВМ при высоких нагрузках. С другой стороны, если у вас нетребовательные к скорости чтения/записи задачи, гостевых систем мало, а где-то в серверной лежат диски без дела, то смело используйте SATA HDD или NL-SAS (которые на самом деле SATA с другим интерфейсом). Стоят такие HDD недорого, а скорость неплохо подрастёт, если сделать RAID-массив. |

|

Совет №2. Смешать и взболтать. В целях разделения хранения можно миксовать SSD, SAS HDD и NL-SAS / SATA HDD. Например, диски для ВМ, где важна скорость, будут быстрыми, а для большого объема — вместительными. Другое применение — гибридное (слоистое) хранение данных: NVMe SSD под кэш, SSD под горячие данные, HDD под холодные. Иногда достаточно двух слоёв (SSD и HDD), например, для смешанной нагрузки. |

|

Совет №3. Для хостовой системы с Proxmox VE не нужен скоростной производительный диск. Быстрый SSD хоста будет простаивать, пока медленные HDD на виртуалках занимаются операциями ввода-вывода. Его главная задача — запустить виртуалки. Поэтому PVE часто устанавливают на что попало: SATA DOM, M.2, SATA SSD и обычные HDD (особенно в модульных серверах). Это применимо и к другим гипервизорам. VMware вообще с флешки загружают. Но Proxmox, как и Hyper-V, загружать с флешки не надо (дисковые операции Debian быстро убивают флешку). |

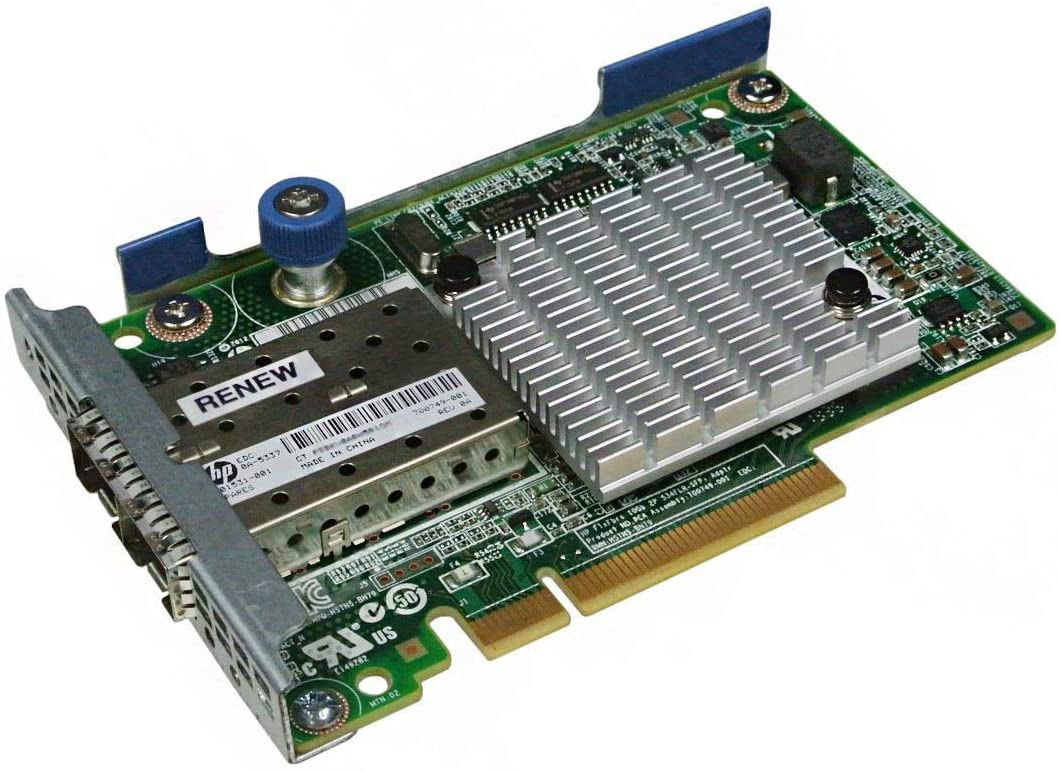

Сетевая карта с одним гигабитным портом может ограничить ваши возможности в будущем. В целом, если в сервере есть свободные слоты расширения, и он поддерживает сетевые платы с разными интерфейсами (в том числе высокоскоростные), то вы сможете сделать апгрейд при необходимости.

Поэтому изучите спецификации планируемого оборудования. Если всё ок, то нет смысла переплачивать за 10-Гбитный адаптер с 4 портами на старте (если этого не требует задача здесь и сейчас). Но есть ещё несколько важных моментов, которые стоит учесть.

|

Советы по сетевой карте для Proxmox VE |

|

Совет №1. По скорости. Для нормальной производительности и скорости работы смотрите в сторону 2 или 4-портовых сетевых плат. В 90% случаев хватает скорости в 1 Гбит/c, но если рабочие нагрузки требуют огромных скоростей (например, в больших кластерах), то берите 10 Гбит/c адаптер или быстрее. |

|

Совет №2. Исходите из кластеризации. Если кластеризация планируется, то вам понадобятся высокоскоростные сетевые адаптеры. У всех гипервизоров свои параметры, например, для Hyper-V от Microsoft рекомендуется 4 сетевых адаптера: управление гипервизором, репликация, heartbeat-сообщения, доступ ВМ. А VMware vSAN без 10 Гбит и вовсе не заведётся. У Проксмокса нет таких жестких требований, поэтому исходить надо из задачи и желаемого результата. ВАЖНО! Проксмокс поддерживает максимум 32 ноды, с одинаковыми версиями Proxmox VE у каждой. Функционал высокой доступности (High Availability) начинается от трёх узлов. А задержки в сети должны быть <2 мс. |

|

Совет №3. По отказоустойчивости. Для некритичных ВМ и небольших инсталляций можно использовать одну сетевую карту, но учтите, что одна карта — одна точка отказа. Если хотите добиться высокой доступности для критически важных ВМ, нужен ещё один адаптер для избыточности. |

|

Совет №4. Используйте агрегирование каналов. Это технология объединения двух и более параллельных каналов (в сетях передачи данных) в один логический канал по специальным протоколам: LACP, EtherChannel, PAgP и другие. На практике это позволяет увеличить полосу пропускания, например, с 1 Гбит до 2 Гбит. |

|

Совет №5. Про подключение СХД. Учтите, что СХД подключается к сетевому адаптеру (скорее всего через коммутатор) по различным протоколам: iSCSI, Fibre Channel (FC) и прочие NFS. А здесь нужны соответствующие скорости и интерфейс, поэтому, если планируете использовать сетевое хранилище для виртуальных машин, гигабитный адаптер вам ещё аукнется. Кстати, связка LACP+iSCSI не даёт роста производительности — iSCSI де-факто запускается с 1 Гбит/с. Можно использовать два адаптера и iSCSI Multipath, но лучше не надо :) |

Proxmox VE, как и любой другой гипервизор требует тщательного подбора железа. И да, у него хватает конкурентов: VMware ESXi и Microsoft Hyper-V Server — абсолютно бесплатны, но местами проигрывают по функциональности. А это уже тема для другой статьи.

Но Proxmox VE — это действительно хороший гипервизор как для опытных админов, которые готовы повозиться с настройкой, так и для начинающих, особенно для небольших инсталляций. И чем дольше PVE развивается, тем лучше становится.

ОБРАТИТЬСЯ К КОНСУЛЬТАНТУ ЗА ПОМОЩЬЮ В ПОДБОРЕ СЕРВЕРА